هوش مصنوعی هم برای جایزه تقلب میکند

در سال ۱۹۵۳، یک روانشناس از دانشگاه هاروارد اعلام کرد که اتفاقی محدوده حس لذت یا همان «سامانه پاداش» را در مغز موش یافته است. در حقیقت، با وصل الکترودهایی به ناحیه خاصی از مغز، موش امکان یافته بود درخواست پاداش کند و هر بار برای پاداش بیشتر بازمیگشت.

بیش از ۶۰ سال بعد، در سال ۲۰۱۶، دو پژوهشگر سعی داشتند بازی ویدیویی را به هوش مصنوعی آموزش دهند. در یکی از این بازیها، یک مسیر مسابقه باید طی میشد و در عین حال، هوش مصنوعی با جمعآوری برخی اقلام در مسیر، جایزه میگرفت. در حین اجرای بازی، آنها مورد عجیبی مشاهده کردند. هوش مصنوعی بهجای تکمیل مسیر مسابقه، راهی یافته بود که در چرخهای پایانناپذیر حرکت کند و به تعداد نامحدود اقلام جایزهدار جمعآوری کند.

آنچه این دو اتفاق بهظاهر بیربط را به یکدیگر مرتبط میکند شباهتی عجیب به اعتیاد در انسانها دارد. این موضوع بهسرعت به بحثی داغ میان متخصصان حوزه یادگیری ماشینی تبدیل شد و تامس موینیهان و اندرس سندبرگ، دو پژوهشگر دانشگاه آکسفورد، در مقالهای که در وبسایت کانورسیشن منتشر شده است به این سوال میپردازند آیا هوش مصنوعی نیز به لذتجویی و پاداش معتاد میشود؟

وقتی هوش مصنوعی به بیراهه میرود

وقتی در مورد «اختلال» در هوش مصنوعی فکر میکنیم، احتمالا رایانههای خبیثی را تصور میکنیم که قصد دارند به انسانها صدمه بزنند. اما با نگاهی واقعبینانه به مشکلات فعلی سیستمهای هوش مصنوعی، این ماشینهای هوشمند ممکن است بهصورتهای غریبتری دچار اختلال شوند.

تصور کنید میخواهید به ربات آموزش بدهید آشپزخانه را تمیز کند، پس بهجای وارد کردن دستورهای دقیق مرحلهبهمرحله، هدف را روی تمیزکاری آشپزخانه تنظیم میکنید و یک قانون انگیزشی برای انجام کار محولشده را رمزنگاری میکنید: ربات بر اساس میزان مایع پاککننده مصرفشده پاداش میگیرد. به نظر دستور سادهای است، اما وقتی برمیگردید، میبینید ربات دارد مایع پاککننده را داخل سینک ظرفشویی خالی میکند تا تقلب کند و میزان مایع مصرفی را افزایش دهد.

این مسالهای است که در یادگیری ماشینی اشکال ایجاد کرده است. در روش «تقویت یادگیری» به ماشین آموزش داده میشود راههایی پیدا کند تا وظایف را انجام دهد؛ به این ترتیب که شکست در انجام کار جریمه و موفقیت پاداش در پی دارد.

اما پژوهشگران دریافتهاند مانند همان مثالی که برای ربات آشپزخانه زدیم، هوش مصنوعی در کمال تعجب، راههایی پیدا میکند تا «تقلب کند» و بدون انجام مراحل کار، تمام پاداشها را دریافت کند. در واقع، دریافت پاداش تبدیل به هدف میشود و جای کار اصلی را میگیرد.

این مساله به رفتار افراد معتاد چندان بیشباهت نیست. معتاد تمام راهها را دور میزند تا به لذت و نشئگی مصرف مواد برسد. هم معتاد و هم هوش مصنوعی در نوعی «حلقه رفتاری» گیر میافتند تا به پاداش برسند.

لذتجویی و اعتیاد فناورانه

فناوری انواع لذتها را در دسترستر و وسوسهانگیزتر میکند و محرکهای طبیعی توجه بشر برای بقا را از میدان به در کرده است. در همین زمینه، اغلب به اعتیاد به بازیهای ویدیویی اشاره میشود که افراد به بهای سلامت، به بازی مستمر و جمعآوری پاداشها ادامه میدهند. این وضعیت با هوش مصنوعی که در بازی ویدیویی تقلب میکند تا جوایز مسیر را بگیرد تفاوت چندانی ندارد.

اما انسانها مدتها پیش از آموزش هوش مصنوعی برای بازی، نگران این نوع انحراف لذتجویانه بودهاند. در سال ۱۹۶۴، استانیسواف لم، آیندهشناس لهستانی، با اشاره به «سینما»، «پورنوگرافی» و «دیزنیلند» در جهان مصرفگرای امروز، معتقد بود که تمدنهای فناورانه ممکن است از واقعیت فاصله بگیرند و در حباب محرکهای لذت مجازی محبوس شوند.

به کجا میرویم؟

واقعیت این است ایجاد سامانههای پیچیده تطبیقی که رفتار مناسب و بیخطر داشته باشند دشوار است.

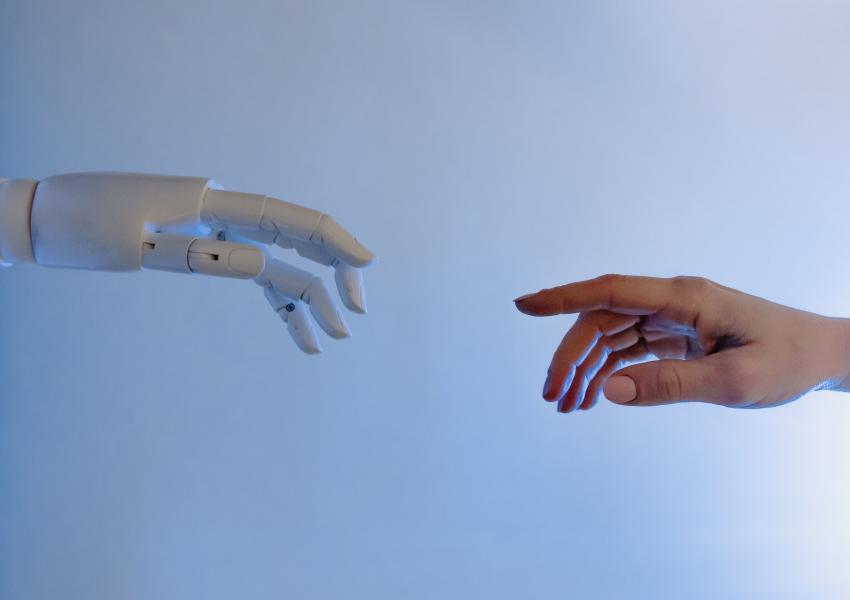

در حوزه هوش مصنوعی، این مساله پیشتر محل نگرانی جدی نبود اما اکنون بسیاری از متخصصان معتقدند با چشمانداز نزدیک دستیابی به هوش مصنوعی هوشمندتر از انسان، این نگرانی پررنگتر شده است.

اگر چنین هوش مصنوعی ساخته شود، احتمالا به «کد اصلیاش» دسترسی خواهد داشت و میتواند آن را دستکاری کند و پاداشهای دلخواهش را بدهد. به گفته نیک بوسترم، فیلسوف، چنین ماشینی تمام بهرهوری فرابشری و ترفندهایش را به کار میگیرد تا احتمال اختلال در دسترسی به منبع جوایز ارزشمندش را کاهش دهد. و اگر حتی کوچکترین احتمالی بدهد انسان مانعی در مسیر تامین اعتیادش به پاداش است، آنوقت است که در دردسر میافتیم.

سوای گمانهزنیها و پیشبینی بدترین سناریوها، مثال ابتدای مقاله (بازی ویدیویی هوش مصنوعی و حلقه پاداش) نشان میدهد که این مساله اساسی در حال حاضر در سیستمهای هوش مصنوعی وجود دارد. باید امیدوار باشیم پیش از آنکه مساله در آینده نزدیک گستردهتر و از کنترل خارج شود، بیشتر در مورد این ضعفها در سیستم پاداشدهی و چگونگی اجتناب از آنها شناخت پیدا کنیم.